Pensar que la Inteligencia Artificial (IA) son exclusivamente robots es un error. Al menos, en gran parte. Porque este sistema tecnológico de plena actualidad va mucho más allá y es mucho más antiguo de lo que parece. Tanto, que el término comenzó a acuñarse en la década de los 50, pese a que su auge y popularidad es más bien reciente. Muy reciente. Pero, entonces, ¿de qué se trata este avance que pretende hacer más fácil la vida a las personas?

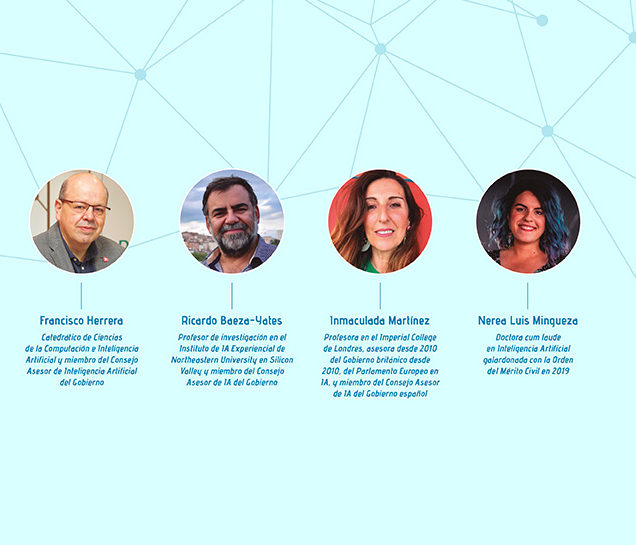

“La IA son algoritmos alimentados por datos que permiten dar respuesta a una pregunta”, responde a Capital Francisco Herrera, catedrático de Ciencias de la Computación e Inteligencia Artificial y miembro del Consejo Asesor de Inteligencia Artificial del Gobierno. Este explica: “Pongamos que quiero poder distinguir una ballena en el océano. Para ello, crearé una base de datos de imágenes donde, a partir de una operación matemática, mi sistema sabrá que 1 es ballena y 0 no lo es. En ese punto, yo proporcionaré de miles de imágenes de ballenas de gran resolución a mi base de datos para que, con mucho entrenamiento, sepa distinguir finalmente si lo que tiene delante es un alga o el objeto en cuestión”. Y así es cómo, una vez se alcanza una ratio de acierto prácticamente plena, se puede dar por validada esta ayuda para el transporte marítimo.

El problema, confiesa Herrera, es que “si el algoritmo se entrena con sesgos, el sistema de IA estará sesgado”. ¿Qué significa esto? “Que si los datos no están bien etiquetados se pueden dar casos de discriminación”, reconoce, por su parte, Ricardo Baeza-Yates, profesor de investigación en el Instituto de IA Experiencial de Northeastern University en Silicon Valley y miembro del Consejo Asesor de IA del Gobierno español.

Este investigador rememora con Capital cómo, en 2018, el algoritmo de Deliveroo discriminó a parte de sus trabajadores “por el mero hecho de que trabajaban en un horario en el que había menos clientes”. Aunque también podría haber sido, como ha ocurrido en algunos casos, por temas de género o etnias. “En aquel caso fue una discriminación indirecta porque el algoritmo estaba entrenado para vender más. Y los riders que no repartían en el horario de la cena, que es cuando más clientes había, eran discriminado".

Por eso, Baeza-Yates es un férreo defensor de la necesidad de una regulación ética en el desarrollo de sistemas de IA, ya que, a su parecer, “los algoritmos no son autónomos, aprenden a serlo, y por ello hay que enseñarles a que se preocupen por el bienestar de la sociedad y no sólo busquen el beneficio específico de un producto”.

Esto mismo es lo que planteó la Comisión Europea en su Libro Blanco sobre la IA publicado en febrero de 2020 –“la inteligencia artificial es una tecnología estratégica que ofrece numerosas ventajas a los ciudadanos, empresas y a la sociedad, siempre y cuando sea antropocéntrica, ética y sostenible y respete los derechos y valores fundamentales”– y ha vuelto a recordar en su hoja de ruta para la regulación de la IA difundida este abril de 2021 –“la Comisión ha propuesto una legislación para regular y asegurar la protección de los principios éticos en la IA”–. Y razones no faltan.

“La IA puede permitir nuevas manipulaciones, adicciones, de control social y vigilancia indiscriminada que son particularmente dañinas, y deben prohibirse por contraponerse a los valores de la Unión Europea de respeto de la

dignidad humana, libertad, democracia, estado de derecho y respeto de los derechos humanos (DD.HH.)”, reza uno de los puntos más destacados de la hoja de ruta publicada por la Comisión Europea que más aplaude Baeza-Yates. “Más que mala praxis, es pura ignorancia por parte de las empresas, que piensan en lo que quieren hacer, pero no en lo que puede pasar y qué tipo de discriminación generan”, sentencia este investigador y defensor del buen uso de esta tecnología tan beneficiosa como peligrosa.

Al ya citado caso de Deliveroo se pueden sumar otros tantos, pero Inmaculada Martínez, profesora en el Imperial College de Londres, asesora desde 2010 del Gobierno británico, del Parlamento Europeo en IA, y miembro del Consejo Asesor de IA del Gobierno español, recalca uno: “La mujer está excesivamente discriminada”.

LA APLICACIÓN DE LA IA EN LAS PYMES, UNO DE LOS GRANDES OBJETIVOS CON MÚLTIPLES USOS

Discriminación femenina

“Si nos fijamos en la medicina, todo se basa en el cuerpo del hombre y no se analizan los efectos de un determinado medicamento en el cuerpo del a mujer”, argumenta esta experta en IA, que explica a Capital que “esto ha sucedido de forma idéntica en el desarrollo de tecnologías de detención de enfermedades basadas en IA”. Por eso, sentencia: “Quiero, ruego, que haya más mujeres en este campo porque vivimos dentro de unos parámetros que han sido creados por hombres y en los que han primado sólo sus propios datos”.

En concreto, actualmente la cifra de mujeres en puestos técnicos de IA ronda el 12%. Unos números ínfimos para equilibrar esa tendencia histórica en el entrenamiento de los algoritmos. La Secretaría de Estado de Digitalizacióne Inteligencia Artificial se ha fijado en esta situación al exponer en su Estrategia Nacional (ENIA) la necesidad crítica de reducir la brecha digital aumentando en un 80% la formación en estas materias y asegurando que el 50% sean mujeres. Un proyecto para el que, tal y como ha argumentado Carme Artigas, secretaria de Estado en Digitalizacióne IA, en este número de Capital, se destinarán 3.700 millones de euros en los próximos tres años.

Unas palabras que Nerea Luis Mingueza, una de las caras más jóvenes y reconocidas de la IA en España, doctora cum laude en Inteligencia Artificial y receptora de la Orden del Mérito Civil en 2019 con solo 28 años, así lo celebra: “Es una buena noticia, porque cuanta más diversidad haya, más rica será la tecnología. Y no sólo es importante que estos programas de formación y estos principios éticos se apliquen a las mujeres, también a otros colectivos como el LGTBI o la diversidad étnica”.

LEE EL REPORTAJE COMPLETO EN EL NÚMERO DE MAYO DE CAPITAL, YA LA VENTA EN KIOSCOS.